行业热点 | Sora 2遇冷背后:Video RLHF的崛起

2025-12-23发布

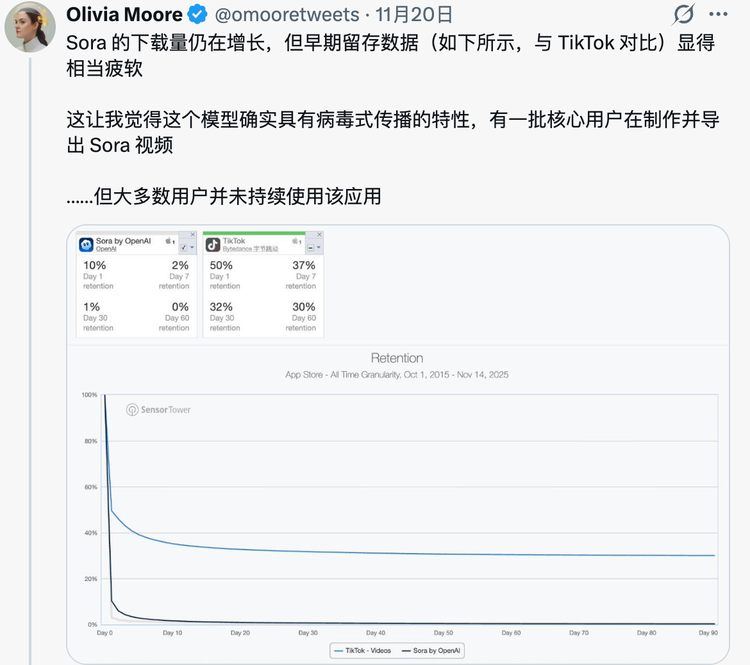

AI产品的每一次改版都能引起一次轰动,而最近较为热闹的莫过于Sora 2。作为AI圈里的长期爆火产品,今年Sora 2刚上线就引起了百万下载。但没过几天,就呈现出持续下滑的趋势。

根据A16Z合伙人Olivia Moore披露的数据,OpenAI寄予厚望的Sora App,30 天留存率仅为1%,而60天留存率则残酷地接近0%。

大部分用户在下载试用之后,反馈Sora 2的表现并不理想,它的宣传片堪称完美,但实际使用上却是槽点满满。

“想生成一个喝水的视频,结果杯子直接穿过了脸。”

“让它画一个人转身,转着转着衣服换了一套。”

“以前是只有几秒钟,现在虽然能生成一分钟,但逻辑崩坏得更明显了。”

Sora 2的APP评分的下滑,其实向大众揭示了一个必须正视的事实:现在的视频大模型,其实还没有做到非常完美,它依然只是一个偏科的天才。虽然它在画质和光影上经常让人啧啧称奇,但在物理规律和逻辑因果上,它又显得有些弱智了。

在普通用户唱衰的同时,作为AI数据服务商,我们却看到了隐藏的机会:Sora 2的不完美,说明了视频大模型的预训练已经触顶,而技术的突破则藏在了数据标注的最后一公里。

一、AI视频生成的现实困境

目前的很多视频大模型(包括Sora)的困境,不在于模型能力不够,而在于一个更根本的原因:它还没有真正对齐现实世界。这一点,其实和当年GPT-3阶段的语言模型非常相似。尽管模型能力已经很强,但输出仍然不可控、不可靠。

后来GPT是怎么迭代优化的呢?其实靠的就是 RLHF(人类反馈强化学习)。如今,视频大模型也走到了这一步。

如果说预训练是让视频大模型看了上亿小时的视频,学会了照猫画虎,那么Video RLHF就是让视频模型重点理解:生成的视频内容是不是符合人类对真实世界的预期。这是一种偏好对齐,而不是规则枚举。

Sora 2的遇冷,与其说是技术层的失败,不如说是对齐(Alignment)工作的滞后。

二、Video RLHF:连接AI与现实的桥梁

和我们认知的传统视频标注不同,Video RLHF不再是只提供一些客观类标签,而是要引入人类的偏好判断。这种判断正是视频大模型最缺乏、也最难获取的部分。

在实际操作中,Video RLHF往往从指令遵循开始。模型生成的视频是否真正明白了Prompt的核心意图,而不是为了完成任务而完成。这种判断没办法让模型通过规则来自动完成,只能依赖于人类对语义完整性的理解。

更复杂的部分在于物理和逻辑一致性,标注员需要在连续的视频中找到那些微妙但很致命的问题,比如物体的接触关系是否合理、动作是否连贯、光影变化是否符合实际场景。这一类的问题对标注员的要求,远高于传统的视频标注。

更高阶的判断还涉及到美学偏好和安全判断。比如什么样的画面更自然、更舒服,什么内容虽然能AI生成,但并不适合进行发布与公开。这一类的判断更具人类主观性。

Video RLHF的核心价值在于构建偏好结构,通过成对排序、偏好对比及失败样本修复建议等方式,比绝对评分更能有效指导模型优化。

三、数据标注:从生产到校准的角色升级

随着视频大模型不断向产品端推进,数据的需求结构也在发生转变。越来越多的AI企业明白,模型的问题不只是缺少数据,还缺少对齐工作。他们需要的不再是海量通用视频数据,而是能直接校正模型行为的高质量反馈数据。

这也意味着,数据标注正在从简单的生产环节转向高难度的校准环节,标注员也不再是单纯的执行标注任务,而是更多地参与到视频模型行为的强化训练过程,承担起多轮审核、专家标注、反复校准等重任。这样的高质量标注虽然在一定程度上影响了研发成本,但是会比以往的反复调整模型参数更有效果。

结语:

Sora 2的产品遇冷,并不是一个孤立事件,而是整个视频生成行业都要面对的共同问题。

当模型能力足够强之后,真正决定产品成败的,反而是那些最基础、最具主观性的判断:这个视频看起来像不像真的?内容是否符合常识?行为是否符合物理逻辑?

AI虽然在某种意义上是万能的,可以生成无数种可能性,但是现实世界中只有一种正确答案。Video RLHF的价值,就在于不断把模型的生成能力与这个实际答案相匹配。

当视频模型开始真正构建World Model,人类反馈不再是辅助工具,而是不可替代的核心机制。未来,视频大模型的成功与否,将很大程度上取决于我们能否认真教会它们什么是现实。